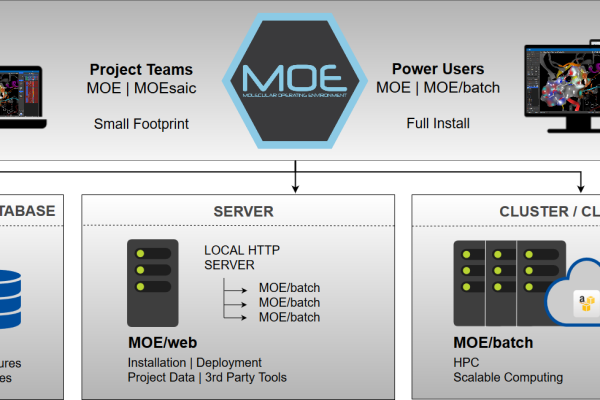

Escalando MoE en Clusters de GPU para Entrenamiento Distribuido

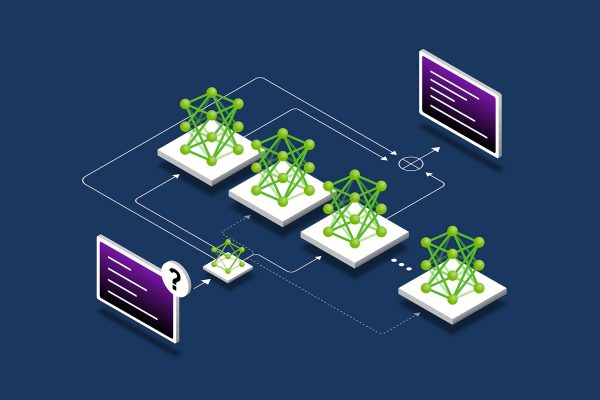

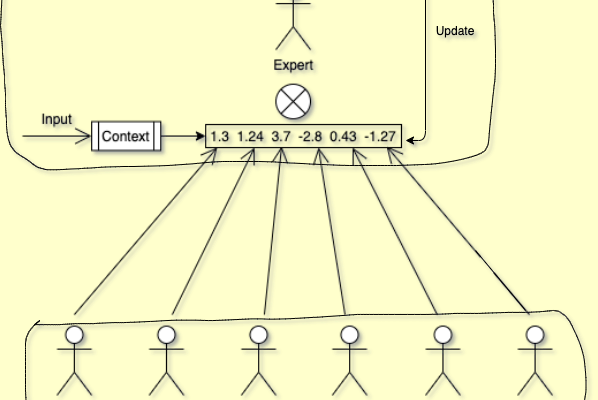

Escalando MoE en Clusters de GPU para Entrenamiento Distribuido El entrenamiento de modelos MoE (Mixture of Experts) en clusters de GPUs presenta desafíos únicos debido a la distribución desigual de la carga de trabajo. A diferencia de los Transformers densos, donde todas las GPUs comparten la carga de manera uniforme, en MoE cada «experto» se…